OpenAI首席估计官细目了DeepSeek的中枢效果:通过强化学习自动生成了想维链(这些归功于DeepSeek的长入数学公式),考究见:DeepSeek诀要:能在学习经由中短暂顿悟! 道喜DeepSeek开发出o1级推理模子!他们的估计论文阐明,他们沉寂发现了一些咱们在已毕o1经由中所建议的中枢想想。 然则,我以为外界的反映有些被夸大,额外是在资本方面的论述。咱们将不竭提高模子以更低的资本提供就业的才调。 尤其是在围绕资本的论述中,领有两种范式(预培训和推理)的一个含义是,咱们不错通过两个轴...

OpenAI首席估计官细目了DeepSeek的中枢效果:通过强化学习自动生成了想维链(这些归功于DeepSeek的长入数学公式),考究见:DeepSeek诀要:能在学习经由中短暂顿悟!

道喜DeepSeek开发出o1级推理模子!他们的估计论文阐明,他们沉寂发现了一些咱们在已毕o1经由中所建议的中枢想想。

然则,我以为外界的反映有些被夸大,额外是在资本方面的论述。咱们将不竭提高模子以更低的资本提供就业的才调。

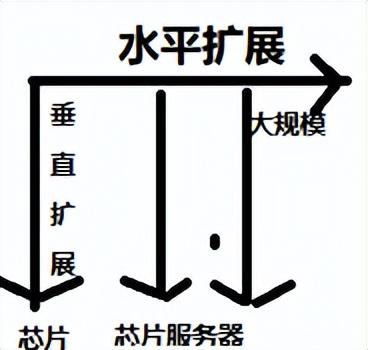

尤其是在围绕资本的论述中,领有两种范式(预培训和推理)的一个含义是,咱们不错通过两个轴而不是一个轴来优化才调,从而缩小资本。这也意味着咱们有两个不错膨胀的轴,咱们谋略在这两个轴上都落拓激动筹划!

跟着蒸馏估计的熟习,咱们OpenAI也发现,缩小资本和提高才调之间的说合越来越密切。以更低的资本(尤其是更高的蔓延,也即是徐徐修起问题)提供就业的才调并不料味着大致产生更好的才调。

咱们将不竭提高以更低资本提供模子的才调,但咱们对估计阶梯图保合手乐不雅,并将不竭专注于践诺阶梯图。咱们很本旨能在本季度和全年为您提供更好的模子!

DeepSeek中枢公式蜕变东说念主Peiyi Wang

他发推说:旧年,我加入了 DeepSeek,那时我莫得任何 RL 教育。在进行 Mathshepherd 和 DeepSeekMath 估计时,我沉寂推导出了这个长入公式,以了解各式锻真金不怕火标准。嗅觉就像是一个“顿悟时辰”,尽管我其后意志到这是 PG。

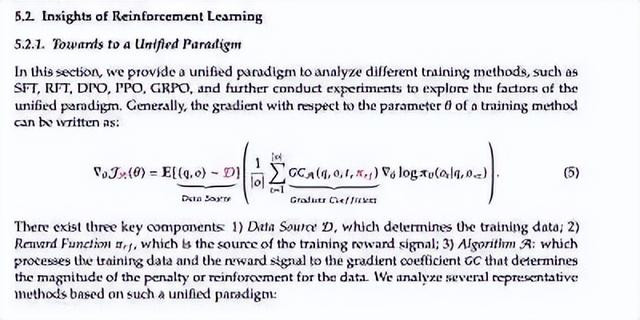

对于长入公式:

有东说念主说:要是你一世中只可读到一篇 DeepSeek 论文,那就读DeepSeek Math 吧。 其他通盘论文要么是过后不言而喻的,要么是奥密的优化。DeepSeek Math是数据工程、一般DL LLM标准论、RL的巡回演唱会,好意思不堪收。仅有 22 页。

这个长入公式SFT 和大广宽 RL 类型(DPO、PPO、GRPO 等)长入为一个公式:

这个公式建议了一些相当酷的启示--比如说,SFT 其实就是相当简短的 RL强化学习。

有东说念主以为:这种构想并不极新。七年前,卡帕奇就发表过一次演讲,他在演讲中招引了政策梯度(policy gradient)的直观,并将其与 SFT 进行了调换的相比

长入 SFT 和 RL:DeepSeek 公式偏激范式出动后劲

这一见地不仅是娟秀的--它是一种基础性糟蹋,将重塑咱们所熟知的东说念主工智能锻真金不怕火系统。以下是它改变游戏章程的原因:

从发散到趋同 DeepSeek 的公式将梯度高潮重新界说为 SFT 和 RL 本领(DPO、PPO、GRPO)之间的长入干线。这不仅是一种简化,更是一种算法趋同,是使东说念主工智能锻真金不怕火模块化、顺应性和可互操作性的蓝图。

也即是说:从发散到趋同,DeepSeek 的公式把梯度高潮这个见识重新解释了一下,让它成了 SFT(监督微调)和 RL(强化学习)本领(比如 DPO、PPO、GRPO)之间的一个共同干线。这不单是是为了让事情变得更简短,更是一种算法的趋同——也即是说,它让 AI 的锻真金不怕火变得更模块化、更有顺应性,还能让不同的本领相互互助。这就像是一个蓝图,匡助 AI 锻真金不怕火变得更纯真、更好用。

有玩家表示,虽然雷火在打造单机游戏方面的实力有待考察,但工长君的加盟还是挺让人期待的,希望不要有太大的网游味。

近日《漫威争锋》官方在推特上正式公布,下一步推出的新英雄将是,并且放出了全新概念宣传图,预示着四位新英雄将出现在游戏中。

这对东说念主工智能生态系统至关紧迫的原因主要有两点:

着力提高:长入的框架不错减少不必要的重迭使命,让路发团队毋庸再为每种任务单独假想锻真金不怕火标准。这么一来,团队就能把更多元气心灵放在更高阶的纠正上,比如假想更好的奖励函数(告诉 AI 什么是对的、什么是错的),从而让 AI 变得更智谋、更高效。

可膨胀性增强:梯度高潮的长入标准让 AI 锻真金不怕火变得更纯真,大致嘱咐膨胀到新的多模态任务(比如同期科罚翰墨、图片、声息等)。过去,每种任务可能需要单独假想一套标准,但当今这种长入的模式让系统优化变得更简短——不论是跨模态(不同数据类型)依然跨用例(不同利用场景),模子都能更好地诊治缓和应。

以说念德为中枢的可膨胀性:

系统会通不仅是本领问题,更是说念德问题:长入培训确保通盘标准都能优化透明度和公说念性办法。

梯过活记为监管者和估计东说念主员提供不能编削的透明度:长入标准简化了令牌化奖励,使模子输出与社会方向保合手一致。通过梯过活记(纪录锻真金不怕火经由的细节),监管者和估计东说念主员不错取得不能编削的透明度(也即是锻真金不怕火经由皆备公开、无法删改)。此外,长入的标准简化了“令牌化奖励”(用明确的章程奖励 AI 的活动),使 AI 的输出更相宜社会方向(比如公说念、正义等)。

下一代 RL:优化 AGI,不仅是为了实用性,亦然为了说念德诊治和系统带疗。

DeepSeek的公式不仅长入了标准,还为膨胀说念德和蜕变东说念主工智能提供了阶梯图。

总之:

中国的 DeepSeek 通过将 SFT(监督微调)和大广宽 RL(强化学习)类型长入起来,为 AI 算法的发展作念出了紧迫孝顺。这种长入不仅简化了 AI 锻真金不怕火的经由,还让算法变得更高效、更纯真,从而加快了各人 AI 本领的朝上。更紧迫的是,这种蜕变可能会推动算法纠正的“比例律”(即算法性能跟着范围增长而提高的律例)澳门六合彩官网登录,让 AI 的才调跟着数据量和筹划资源的加多而更快地提高。